O Commercial Offer Catalog (Catálogo de Ofertas Comerciais) é um conceito amplamente utilizado em setores como telecomunicações, serviços financeiros, energia, e-commerce, e outros segmentos que envolvem a venda de produtos e serviços complexos. Ele funciona como uma base estruturada e centralizada onde todas as ofertas comerciais de uma empresa são definidas, organizadas, gerenciadas e disponibilizadas para os canais de venda.

A seguir, explico detalhadamente os principais conceitos relacionados ao Commercial Offer Catalog:

📚 O que é um Commercial Offer Catalog?

É um repositório centralizado de todas as ofertas comerciais de uma empresa. Nele são definidos os produtos e serviços que podem ser oferecidos aos clientes, bem como as regras de negócio, preços, elegibilidade, promoções, dependências técnicas e combinações possíveis entre os produtos.

🧩 Componentes Principais do Catálogo

-

Produtos e Serviços

- Itens individuais que compõem uma oferta, como internet banda larga, plano de telefonia, seguro, etc.

- Pode conter atributos como: velocidade, franquia, tipo de cobertura, validade, entre outros.

-

Ofertas

- Conjunto de produtos/serviços agrupados com regras específicas.

- Ex: “Combo Família” que inclui TV, internet e telefone fixo com desconto.

-

Preços e Tarifas

- Tabelas de preços, descontos aplicáveis, promoções temporárias e regras tributárias.

- Pode incluir variações por região, canal de venda, perfil do cliente, etc.

-

Regras de Elegibilidade

- Define para quem a oferta está disponível (ex: apenas para novos clientes, ou em determinadas regiões).

-

Validade e Ciclo de Vida

- Período em que a oferta está ativa, expirando depois de uma data específica ou após condições de uso.

-

Relacionamento entre Ofertas

- Regras de compatibilidade, exclusividade ou dependência entre diferentes ofertas ou produtos.

🧠 Benefícios de um Commercial Offer Catalog bem estruturado

- 🔄 Agilidade na criação e modificação de ofertas: Mudanças podem ser feitas rapidamente sem impacto no sistema como um todo.

- 🛠 Reuso de componentes: Produtos e regras podem ser reutilizados em diferentes ofertas.

- 🎯 Personalização: Permite ofertas personalizadas para diferentes segmentos ou perfis de cliente.

- 📦 Unificação de canais: Garante que todos os canais de venda (loja, app, call center, site) ofereçam as mesmas informações e regras.

- ✅ Governança e controle: Facilita a conformidade com regras regulatórias e políticas internas.

🧱 Arquitetura e Tecnologias Envolvidas

- Pode ser implementado usando padrões como:

- TM Forum SID e eTOM, no setor de telecomunicações.

- APIs RESTful para expor o catálogo a sistemas de CRM, portais e apps.

- Soluções COTS (Commercial Off-the-Shelf) como Oracle BRM, Amdocs Catalog, Ericsson e outros.

- Microservices e Headless CMS, em implementações mais modernas.

🌍 Exemplos de uso

- Uma operadora de telecom usa o catálogo para definir quais planos de internet estão disponíveis em cada cidade.

- Um banco usa o catálogo para compor pacotes de serviços bancários com tarifas específicas para clientes universitários.

- Um e-commerce usa o catálogo para definir combos promocionais e personalizáveis com base no histórico de compras do cliente.

Se quiser, posso te mostrar um exemplo prático em modelo JSON ou Java de como um sistema poderia representar uma oferta no catálogo. Também posso explorar como isso se integra com sistemas de CRM, Order Management ou Billing. Quer seguir por aí?

Legal! Vamos explorar um exemplo prático de como uma oferta comercial poderia ser representada em um modelo de dados (JSON) e depois podemos discutir como isso se integra com sistemas como CRM, Order Management e Billing.

📦 Exemplo de uma Oferta Comercial em JSON

{

"offerId": "COMBO_FAMILIA_2025",

"name": "Combo Família 2025",

"description": "Internet + TV + Telefone fixo com desconto exclusivo",

"status": "ACTIVE",

"validFrom": "2025-01-01",

"validTo": "2025-12-31",

"channelsAvailable": ["ONLINE", "CALL_CENTER", "RETAIL_STORE"],

"eligibilityRules": {

"customerType": ["NEW", "EXISTING"],

"region": ["SP", "RJ", "MG"]

},

"products": [

{

"productId": "INTERNET_500MB",

"name": "Internet 500MB",

"price": {

"monthly": 99.9

}

},

{

"productId": "TV_HD_150CANAIS",

"name": "TV HD com 150 canais",

"price": {

"monthly": 79.9

}

},

{

"productId": "TELEFONE_FIXO_ILIMITADO",

"name": "Telefone Fixo Ilimitado",

"price": {

"monthly": 29.9

}

}

],

"bundlePrice": {

"monthly": 169.9,

"discount": 39.8

},

"technicalDependencies": [

"EQUIPAMENTO_MODEM",

"EQUIPAMENTO_TV_BOX"

]

}

🔄 Integrações com Outros Sistemas

🧾 1. CRM (Customer Relationship Management)

- O CRM consulta o catálogo para mostrar ofertas elegíveis no momento da venda.

- Permite recomendar ofertas com base no perfil do cliente.

- Utiliza as regras de elegibilidade do catálogo.

📦 2. Order Management (OM)

- Recebe a oferta selecionada e quebra em componentes técnicos para orquestrar a ativação.

- Garante que todas as dependências técnicas sejam respeitadas (ex: entrega de modem, ativação da linha).

💰 3. Billing (Faturamento)

- Usa o catálogo para saber como calcular o valor da fatura do cliente.

- Identifica preços promocionais, período de vigência, descontos, etc.

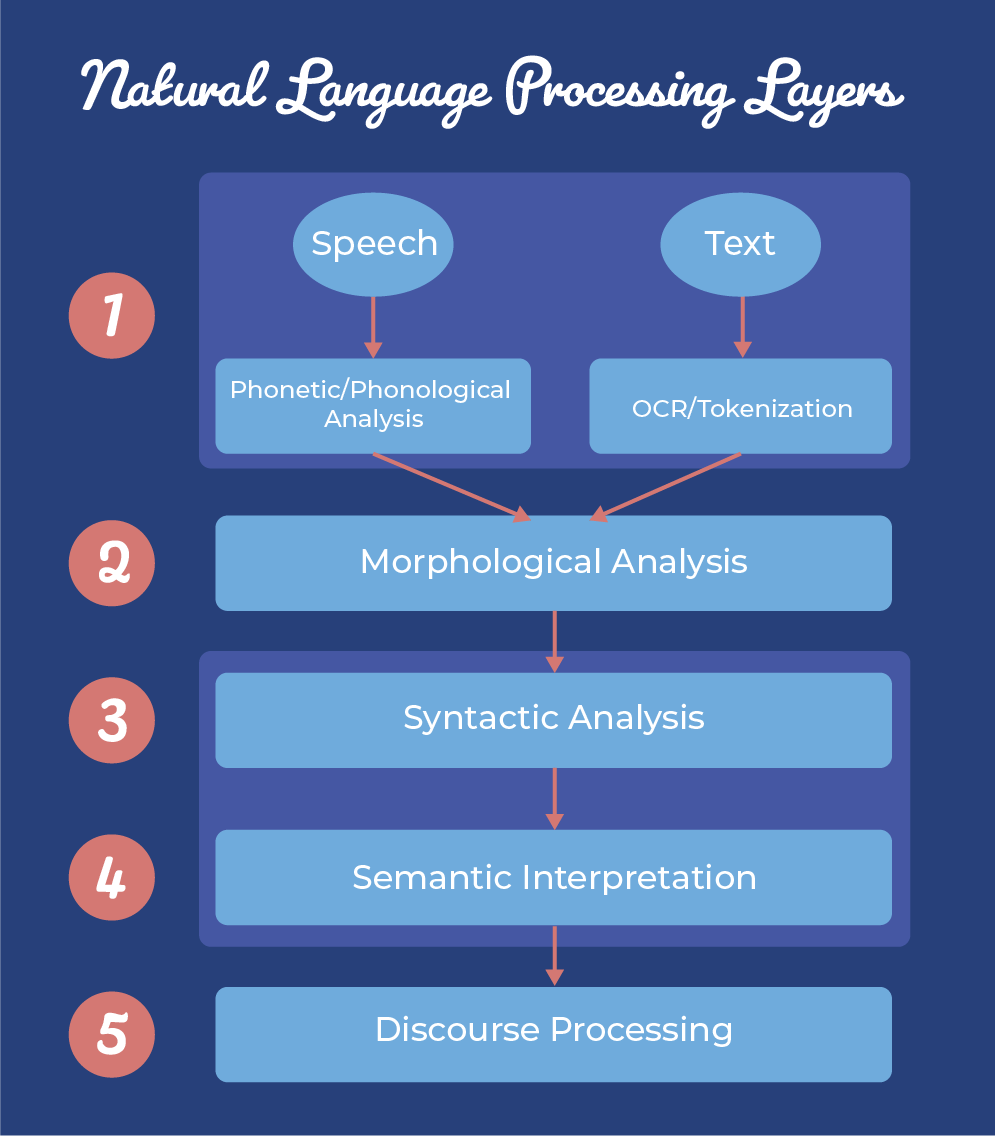

🛠 Arquitetura baseada em microservices (exemplo simplificado)

[Front-End Web/App]

↓

[API Gateway]

↓

[Commercial Catalog Service] ←→ [Product Catalog]

↓

[CRM] ←→ [Order Management System] ←→ [Billing System]

Cada componente consulta o Commercial Catalog Service para garantir consistência.

Se quiser, posso converter esse modelo JSON em um POJO Java com classes como Offer, Product, Price, e até simular um endpoint REST para consumir o catálogo. Quer seguir para a parte Java?