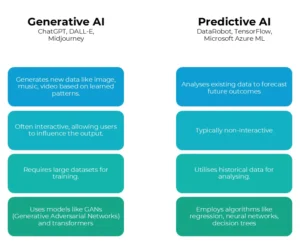

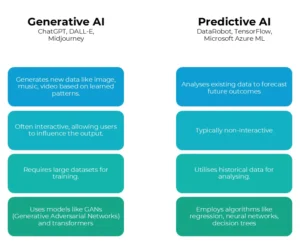

A contribuição da IA vem em duas formas principais: generativa e preditiva. No artigo a seguir, exploraremos as distinções entre IA generativa e preditiva, mostrando como cada tipo está moldando o futuro da resolução de problemas em vários campos.

IA generativa é um tipo de inteligência artificial que pode criar novas informações, como texto, imagens, música ou até mesmo vídeos, com base nos dados em que foi treinada. Em vez de apenas analisar ou processar informações existentes, ela gera novas ideias e resultados.

Imagine que você peça a um modelo de IA generativa como o ChatGPT para escrever uma história curta sobre um dragão e uma princesa. A IA usa o que sabe sobre narrativa, personagens e tramas para criar uma história completamente nova. Ela não apenas copia histórias existentes; ela combina ideias de maneiras criativas para gerar algo único.

Em uma aplicação prática, a IA generativa pode ser usada na arte. Por exemplo, um modelo de IA pode se inspirar em milhares de pinturas e criar uma obra de arte totalmente nova que nunca foi vista antes, misturando estilos e técnicas de maneiras inovadoras.

IA Preditiva

IA preditiva se refere à tecnologia que usa dados, algoritmos e aprendizado de máquina para prever resultados futuros com base em dados históricos. Ela analisa padrões e tendências para fazer suposições fundamentadas sobre o que pode acontecer a seguir.

Por exemplo, imagine uma loja que quer saber quantos sorvetes estocar para o verão. A loja analisa dados de vendas de verões anteriores, incluindo fatores como temperatura, eventos locais e promoções. Usando IA preditiva, a loja analisa esses dados para encontrar padrões, como como dias quentes levam a mais vendas de sorvete.

A IA prevê que em dias em que a temperatura estiver acima de 30°C, as vendas de sorvete aumentarão em 50%. Com base nessa previsão, a loja decide estocar mais sorvete em dias ensolarados, garantindo que eles tenham o suficiente para os clientes sem estocar demais.

Embora ambos os tipos de IA sejam poderosos, eles atendem a propósitos diferentes. Vamos entender as principais diferenças.

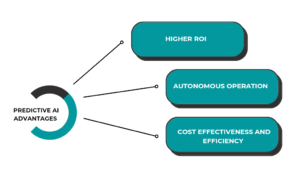

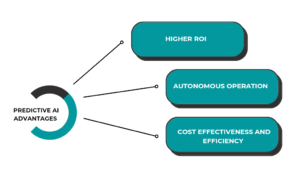

IA preditiva – vantagens

Enquanto a IA generativa atrai atenção por seus novos recursos na criação de conteúdo, a IA preditiva continua sendo uma ferramenta poderosa para melhorar a eficiência operacional e gerar economias substanciais de custos em processos de negócios estabelecidos.

Maiores retornos sobre o investimento

A IA preditiva aprimora as operações existentes, levando a melhorias significativas de eficiência. Por exemplo, a UPS, empresa de serviços globais de remessa e logística, economiza US$ 35 milhões anualmente ao otimizar rotas de entrega, enquanto os bancos podem economizar milhões ao prever com precisão transações fraudulentas. Essa tecnologia tem um histórico comprovado de entrega de altos retornos por meio de processos sistemáticos que as empresas já estabeleceram.

Operação Autônoma

A IA preditiva geralmente funciona sem intervenção humana, tomando decisões instantâneas com base na análise de dados. Por exemplo, ela pode aprovar automaticamente transações de cartão de crédito ou otimizar posicionamentos de anúncios em sites. Em contraste, a IA generativa geralmente requer supervisão humana, pois suas saídas precisam ser revisadas quanto à precisão e qualidade, tornando-a menos adequada para tarefas totalmente automatizadas.

Custo-efetividade e eficiência

Os modelos de IA preditiva são tipicamente muito mais leves e menos intensivos em recursos em comparação aos modelos complexos usados em IA generativa. Enquanto os modelos generativos podem consistir em centenas de bilhões de parâmetros e exigir dados extensos para treinamento, os modelos preditivos geralmente precisam de apenas alguns milhares de parâmetros, tornando-os mais fáceis e baratos de implantar.

A IA generativa substituirá a IA preditiva?

A IA generativa e a IA preditiva atendem a propósitos e funções diferentes, fazendo com que uma não seja uma substituição direta da outra. Embora a IA generativa possa aprimorar modelos preditivos (por exemplo, gerando cenários ou simulações com base em previsões), ela não pode substituir totalmente as capacidades analíticas da IA preditiva. Cada uma tem seus pontos fortes e aplicações, e elas podem se complementar em vários campos, mas não são intercambiáveis.

O que reserva o futuro?

O futuro está em investir corretamente para alavancar a parceria entre IA preditiva e generativa. A IA generativa se destaca na criação de conteúdo e soluções inovadoras, enquanto a IA preditiva se concentra na previsão de tendências e otimização de decisões. Juntas, elas aprimoram as operações comerciais, levando a valor mensurável e ROI aprimorado.

Por exemplo, na área da saúde, a IA preditiva prevê resultados de pacientes, permitindo intervenções oportunas, enquanto a IA generativa pode ajudar a criar planos de tratamento personalizados. Em finanças, a IA preditiva analisa dados de mercado para aprimorar estratégias de negociação, enquanto a IA generativa pode auxiliar na simulação de vários cenários de investimento.

Essa sinergia entre IA generativa e preditiva não apenas simplifica processos e aumenta a lucratividade, mas também promove o engajamento do cliente por meio de experiências personalizadas. As empresas que aproveitam os pontos fortes de ambas as tecnologias podem impulsionar eficiências operacionais, responder às necessidades do mercado rapidamente e manter uma vantagem competitiva.

No cenário em evolução da IA, a integração estratégica de capacidades generativas e preditivas é a chave para desbloquear todo o seu potencial, garantindo que as empresas obtenham retornos imediatos enquanto se preparam para um futuro definido pela inovação da IA.